Процент ошибок в работе искусственного интеллекта в медицине зависит от ряда нюансов

22 ноября 2023 09:52:57

По каким причинам искусственный интеллект допускает ошибки, особенно в такой сфере, как медицина, разбирались «Московские ведомости»

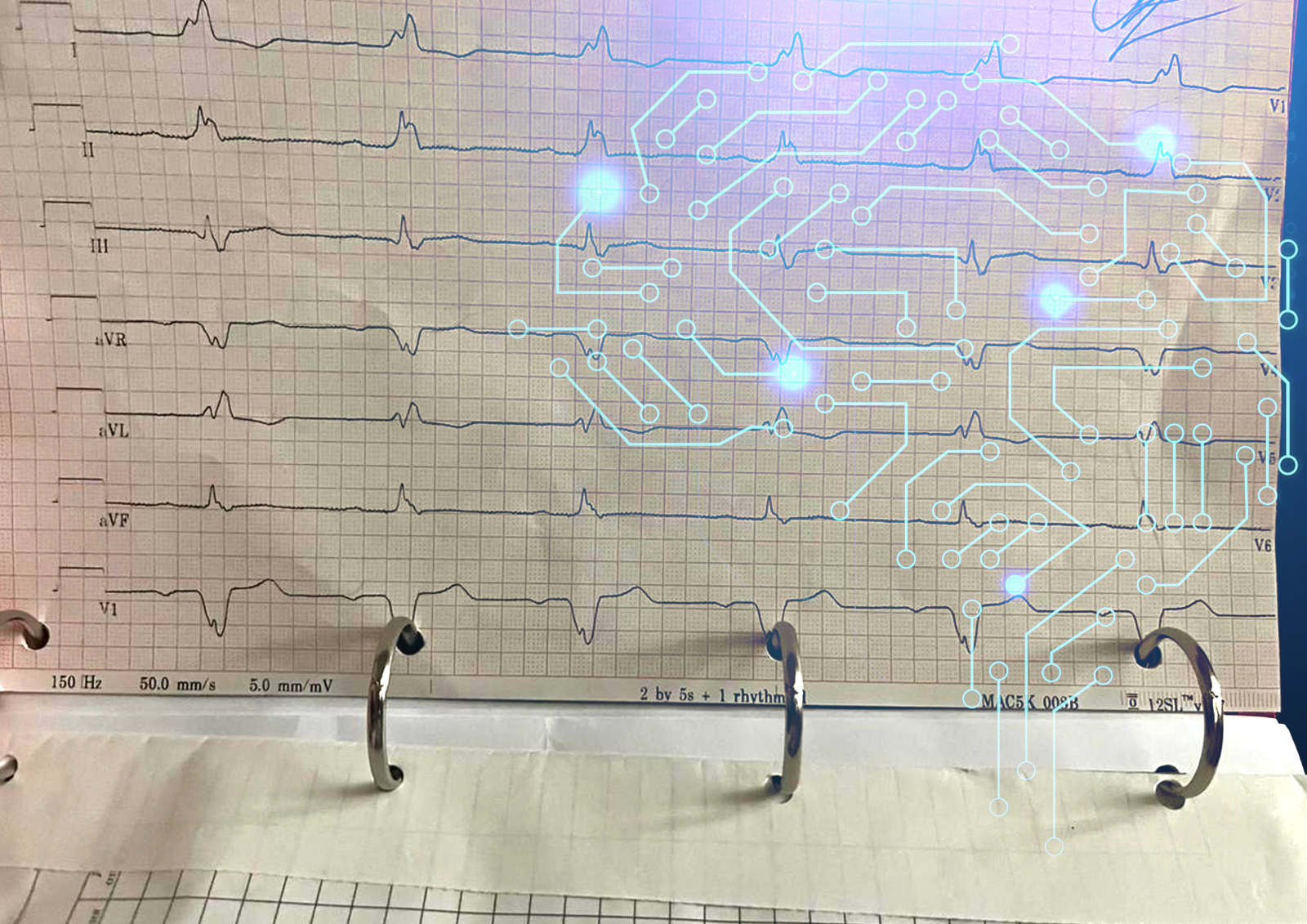

Росздравнадзор приостановил применение медизделия с применением искусственного интеллекта из-за «отсутствия клинического эффекта и неоднократно выявленных дефектов функционирования», речь идёт о зарегистрированной в 2020 году система для анализов снимков компьютерной томографии Botkin.AI, разработанной компанией «Интеллоджик», сообщил «Ъ».

Критерии качества работы ИИ напрямую зависят от решаемых задач, сообщил «Московским ведомостям» директор АНО «Информационная культура» Иван Бегтин.

«Например, в медицине важным критерием является, чтобы точность алгоритма была не ниже, чем точность при принятии решений врачами. Для этого собирают подробную статистику и наборы данных, на которых можно обучать системы автоматизированного принятия решений, так называемые ADM-системы, к которым относят, в том числе системы с так называемым «мягким» ИИ. Ситуация вокруг Botkin AI мне лично неизвестна в подробностях, но в любом случае медицина – это та область, где подобные системы не могут применяться без одобрения регулятора, и регулятор, которым в данном случае выступает Росздравнадзор, должен разрабатывать регламенты одобрения устройств и продуктов с ИИ», — пояснил Иван Бегтин.

Проблема состоит в том, что на решения ИИ в медицинской, правоохранительной, инженерной или любой другой отрасли не стоит излишне полагаться, человек должен перепроверять эти решения, отметил представитель юридической фирмы «Сахаров и партнёры» Никита Истомин.

«ИИ может допускать ошибки, которые могут повлечь за собой последствия разной степени тяжести. Например, врач может поставить на основании ИИ неправильный диагноз. Это может быть ложноположительный или ложноотрицательный результат. В российском и мировом законодательстве есть запрет на автоматическое принятие решений. Так называется способ принятия решений, когда человек вообще исключён, участвует только в качестве оператора или стороннего наблюдателя», — сказал эксперт.

По мнению юриста, ИИ должен проходить обучение, а для этого надо брать откуда-то информацию.

«ИИ нужно брать откуда-то данные, но так, чтобы эти данные никому не принадлежали. Есть понятие персональных данных, закон о врачебной тайне. Клиника не может просто так их раздавать. Они должны быть из открытых источников. В 2021 году ко мне обратилась фирма, которая использовала ИИ, работавший только на одном типе данных – снимках рентгена, – и они его тренировали только на определённые виды заболеваний. Стоял вопрос защиты персональных данных – чтобы персональные данные пациентов не передавались за рубеж, поскольку софт для ИИ находился в России, а некоторые вычислительные мощности и хранилища определённых данных – за рубежом», — рассказал Никита Истомин.

Процент ошибок в работе искусственного интеллекта зависит от того, кто его обучал и насколько качественно, добавил правозащитник.

«Всё зависит от качества данных. В западных странах бывали случаи, когда ИИ ошибался в распознавании лиц людей определённой расы. Данные были большие, но там было 70% людей европеоидной расы, 20% людей негроидной расы, сколько-то процентов монголоидной и маленький процент людей смешанной расы. И в отношении европеоидов процент ошибок был ничтожно малый, а в отношении остальных увеличивался. Но вопрос не только в том, чтобы собрать данные, а ещё и в их качественности и точности. Изображения могут быть разной контрастности, разное освещение у объектов съёмки, разрешение и т.д., и всё это влияет на работу искусственного интеллекта. Нюансов очень много», — заключил собеседник издания «Московские ведомости».